大模型预训练前沿技术报告系列直播课是由中国中文信息学会计算语言学专业委员会主办,并行科技承办的以大语言模型预训练技术为内容方向的系列公益直播课,旨在分享大模型预训练技术前沿学术成果和普及大模型预训练中的超算应用,面向大模型领域的科研工作者和高校师生展开。

大模型预训练前沿技术报告系列直播课计划共举办四场,固定播出档期为每月第三周周四19:00。每期邀请一位大模型领域的知名专家学者,进行约一小时的学术报告分享。直播课的播出平台为:B站【CIPS计算语言学专委会】、视频号【并行科技】、B站【并行科技】。欢迎观看与交流。

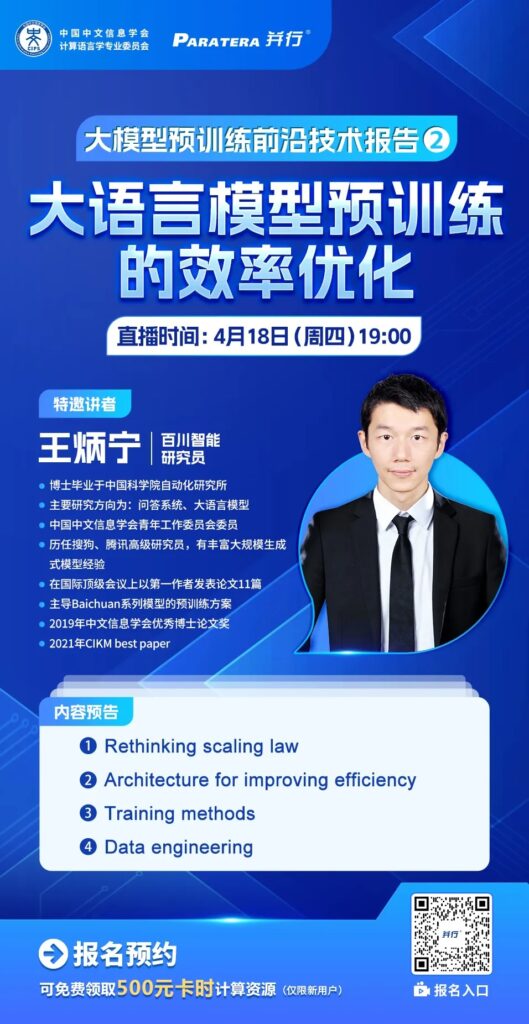

特邀讲者

颜航,上海人工智能实验室青年科学家,博士毕业于复旦大学自然语言处理实验室,师从邱锡鹏教授。研究兴趣包括信息抽取、开源NLP工具建设、大规模预训练模型等。开源平台OpenLMLab主要贡献者,设计并开发了fastNLP、fitlog等开源工具,负责了浦江实验室InternLM大模型的预训练相关工作。在ACL、TACL、EMNLP、NAACL等会议或杂志上发表了多篇论文,2022年获钱伟长中文信息处理科学技术奖一等奖(4/5)。

直播摘要

由ChatGPT引领的大语言模型是当前人工智能技术最前沿的研究方向。基于百亿千亿甚至万亿的自回归无监督语言模型在诸多任务中都达到了惊人的效果。实现大语言模型能力突破的关键方法是所谓的扩展法则(scaling law),即不断的加大预训练模型参数的大小,同时不断提升训练数据量的大小。然而,在真正的预训练过程中,除了本身计算资源的扩展之外,还需要不断提升计算效率,在单位资源时间内对数据进行更高效率的压缩。本报告将着重介绍当前业界在提升预训练效率方向的若干尝试,包括模型结构的优化、训练方案的优化、数据的优化等。

B站观看直播请移步搜索“CIPS计算语言学专委会” B站官方号。