中国中文信息学会(CIPS)计算语言学专委会2024年战略研讨会于6月1日至2日在内蒙古呼和浩特顺利召开。此次研讨会由CIPS计算语言学专委会(简称专委会)主办,内蒙古大学和蒙古文智能信息处理技术国家地方联合工程研究中心承办。研讨会的主题是“大模型的能与不能”。来自全国各地的专委40余位专委会委员参加了本次研讨会,通过特邀报告和论坛研讨的方式,深度探讨了大模型背景下自然语言处理研究所面临的挑战与机遇。

研讨会于6月1日上午8点50分正式开幕。开幕式由专委会副主任、哈尔滨工业大学车万翔教授主持。蒙古文智能信息处理技术国家地方联合工程研究中心主任高光来教授致欢迎辞,对专委们的到来表示了诚挚的欢迎,介绍了内蒙古大学和蒙古文智能信息处理技术国家地方联合工程研究中心的基本情况,鼓励大家抓紧机遇,打好人工智能时代的“大模型底座”,并预祝研讨会圆满成功。专委会主任、清华大学刘洋教授代表专委会对承办单位的办会工作表示由衷感谢,并热烈欢迎与会专委。同时,刘洋教授简要介绍了研讨会设立的目的和专委会的年度工作重点,并对专委会未来发展提出期望。

蒙古文智能信息处理技术国家地方联合工程研究中心主任高光来教授致欢迎辞

专委会主任、清华大学刘洋教授发言

本次研讨会设三组共十一个特邀报告,分别涉及大模型语言能力和大模型任务能力两方面。第一阶段特邀报告由专委会副主任、哈尔滨工业大学车万翔教授和中国科学院自动化研究所刘康研究员主持。北京语言大学荀恩东教授作了题为《大模型下高质量高价值数据》的报告,从计算语言学的内涵演变、NLP研究范式、NLP算法、NLP数据、数据规模增长、类人神经结构、类人认知过程、自然语言处理、知识视角等角度分析了大模型带来的变化,并探讨了高质量高价值数据的层次划分,以及语义和语用角度的概念内涵发展。

北京语言大学荀恩东教授作报告

大连理工大学黄德根教授作了题为《以中文为核心的超大规模机器翻译研究进展》的报告,对大规模机器翻译面临的模型持续学习问题、篇章非自回归解码问题、以及大模型翻译结果的幻觉和偏向性问题进行了讨论,重点报告团队解决上述问题的多种有效方法,并对不同路线的大语言模型机器翻译特点进行了分析,指出了大模型机器翻译未来的研究方向。

大连理工大学黄德根教授作报告

西湖大学张岳教授作了题为《模型生成内容的自动检测研究》的报告,指出人类在辨识AI生成内容上的不足,强调进行模型生成内容检测在构建可信交互、避免AI技术误用方面的必要性,探讨了目前自动检测方法的泛化性方面的不足,并重点报告了团队针对有监督检测和零样本检测的相关解决方案。

西湖大学张岳教授作报告

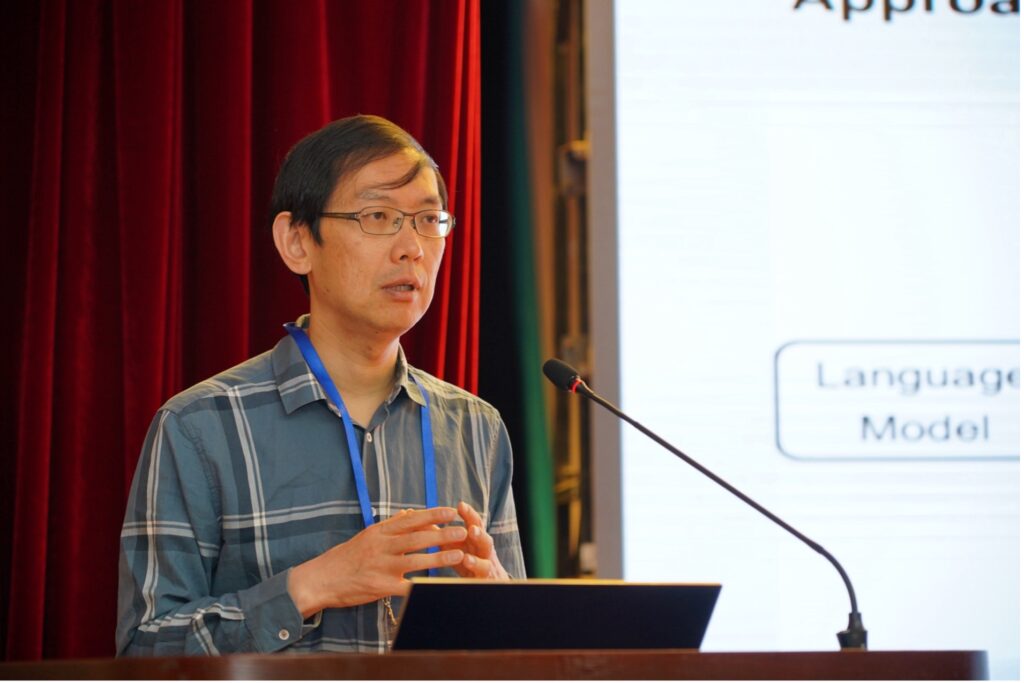

天津大学熊德意教授作了题为《基于评测的大模型安全治理》的报告,探讨了大模型在语言、知识、推理/工具、AGI/ASI四个方面的能力发展,指出了大模型安全治理方面的挑战,包括对齐、评测和监管,详细介绍了团队在大模型评测开展的系统性工作,包括评测体系、评测标准、评测基准、评测平台和评测大赛,为安全可信大模型构建指明了方向。

天津大学熊德意教授作报告

南京大学黄书剑副教授作了题为《大语言模型的多语言能力迁移研究》的报告,指出大语言模型存在数据不平衡问题,即预训练数据以英语为主、非英语数据占比很少,总结团队采用扩展中文词表、中文继续预训练、中文指令微调提升中文大模型的方法,以及通过模型扩展、目标语言预训练、翻译预训练、能力恢复和迁移的多阶段框架实现高效跨语言能力迁移的相关研究成果。

南京大学黄书剑副教授作报告

大会第二阶段特邀报告由西湖大学张岳教授和复旦大学桂韬副研究员主持。北京大学詹卫东教授作了题为《基于空间布局图式的推理题自动生成研究》的报告,指出合成数据具有可扩展、可控制、降低标注成本、增强数据丰富性等诸多优点,重点介绍了结合常识知识和模版构建空间关系知识库的方法,探讨了目前视觉模型在空间生成任务上的不足。

北京大学詹卫东教授作报告

专委会副主任、哈尔滨工业大学车万翔教授作了题为《从语言大模型到代码大模型》的报告,从自然语言到编程语言和从编程语言到自然语言两个角度探讨了自然语言模型掌握编程语言的意义,从预训练、对齐、应用、高阶应用四个层面总结了代码大模型的相关研究进展情况,用详实具体的案例展示了代码大模型的重要应用,并指出了代码大模型未来研究方向。

专委会副主任、哈尔滨工业大学车万翔教授作报告

中国科学院自动化研究所刘康研究员作了题为《大语言模型中的知识探索》的报告,指出大语言模型作为知识库存在知识的事实性、知识激活的鲁棒性、逻辑推理和数值运算、知识更新难等多个问题,报告了团队在大模型知识分析和知识归纳方面的探索性工作和重要发现。报告指出大语言模型可以实现高阶抽象知识的归纳,通过小模型自我演绎产生数据能够提升模型的归纳性能。报告认为探索大模型中知识机制、内外知识协同、知识更新方法及推理方法,是大模型可信、可用的重要问题。

中国科学院自动化研究所刘康研究员作报告

复旦大学张奇教授作了题为《如何提升大模型任务能力》的报告,指出大模型所有的能力都需要精心设计,很多任务的能力在一开始并不具备,而是不断叠加上去的。报告总结了大模型预训练重要经验和结论,探讨了大语言模型训练中多个关键问题,如数学推理、编程和一般能力与SFT数据量的关系如何、导致性能冲突的关键因素是什么、不同SFT策略对复合数据的影响是什么等问题。报告还给出了知识回答和其他任务冲突出现时的解决方案,为大模型训练提供了有价值的参考。

复旦大学张奇教授作报告

中国科学院计算技术研究所冯洋研究员作了题为《大模型增强方法研究》的报告,总结了团队在提升大语言模型在机器翻译任务上表现的多个技术优化方案,包括采用交互式翻译增强模型多语言能力,提升语言生成和与人类对齐能力,通过在真实空间编辑大语言模型的内部表示缓解模型幻觉,设计流式注意力机制和源端、目标端独立位置编码的Decoder-only大模型对流式输入进行实时翻译,结合大语言模型和智能体进行流式翻译,对增强大语言模型在翻译任务上的性能具有很好启示意义。

中国科学院计算技术研究所冯洋研究员作报告

清华大学李鹏副研究员作了题为《开放域大模型智能体》的报告,分析了大模型智能体系统现状,认为当前智能体仍处于发展的初级阶段,距离开放域理想系统仍然具有很大差距。报告指出现有方法框架未遵循智能体-人类-环境统一对齐准则,未完全反映开放域任务特点,难以完全胜任开放域的挑战。报告汇报了团队提出的基于代价约束的工具学习方案、偏好引导的知识传输方案,利用点阵+坐标促进图文协同的主动感知方案,并进一步对统一对齐的未来方向进行了展望。

清华大学李鹏副研究员作报告

专委会主任、清华大学刘洋教授主持了论坛研讨环节。与会专委们就过去一年大模型的进展、大模型的能、大模型的不能、以及大模型未来的发展展开了讨论。大家普遍认为大模型还存在着诸多挑战和机遇,很多问题需要进一步深入探究,学术界和工业界应共同努力,把握机遇,应对挑战,推动计算语言学和大模型技术持续发展。

论坛研讨环节

本次研讨会的召开为国内计算语言学领域的学者们提供了一个充分交流研讨的平台,与会的专委们积极分享了最新的研究成果,深入探讨了当前技术的局限性和面临的挑战,展望了行业的未来发展趋势。这些富有洞见的讨论不仅为与会者提供了启发,也为计算语言学在大模型时代的进一步发展注入了新的动力。这次研讨会的成功举办有助于促进国内计算语言学领域的技术创新,加强计算语言学与相关领域的交流与合作,推动大语言模型的应用和实际问题的解决。

与会专委合影