第二十三届中国计算语言学大会(The Twenty-third China National Conference on Computational Linguistics, CCL 2024)于2024年7月25-28日在山西太原举行,会议由中国中文信息学会计算语言学专业委员会主办,山西大学承办。中国计算语言学大会创办于1991年,由中国中文信息学会计算语言学专业委员会主办。经过30余年的发展,中国计算语言学大会已成为国内自然语言处理领域权威性最高、规模和影响最大的学术会议。作为中国中文信息学会的旗舰会议,CCL聚焦于中国境内各类语言的智能计算和信息处理,为研讨和传播计算语言学最新学术和技术成果提供了最广泛的高层次交流平台。

CCL大会从2017年开始组织技术评测(Evaluation Workshop),为中文语言处理研究者提供测试相关技术、算法和系统的平台。目前已组织评测任务53项,涉及词法、句法、语义、语用,现代汉语和古代汉语等多层面汉语语言处理基础技术,及其在电商、通信、司法、手语等领域的应用,开放多个公开数据集,参赛队伍累计达数千支。

CCL 2024继续组织中文语言处理技术评测。今年大会的评测研讨会(CCL24-Eval)共有十大评测任务,涵盖了语义分析、语言教学、复杂推理、多模态和低资源等五大重要研究方向。每个评测任务都会根据比赛结果设立一、二、三等奖若干名,获奖队伍由中国中文信息学会颁发官方荣誉证书。

为了更好地结合大模型的时代背景,经评测组委会提议,CCL24-Eval首次在评测研讨日程中加入了两个特邀报告。特邀报告分别由大连理工大学的林鸿飞教授和山西大学的谭红叶教授主持。

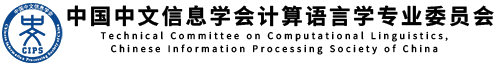

复旦大学张奇教授的特邀报告题目为“大模型能力边界与评测方法思考”。报告从大模型基础理论出发,从预训练阶段的知识压缩和表示学习,到有监督微调阶段的能力注入,再到奖励函数和强化学习阶段的生成能力提升,详细分析了以ChatGPT为代表的大模型能力的获得途径,最后指出,大模型目前落地能达到理想的场景还是很困难,仍然需要逐项优化各类细分任务。同时,张奇教授还提到,“数据集+评测”牵引了人工智能的发展,但现如今各类NLP算法快速发展,大模型已经刷爆了很多榜单,很多评测已经失去意义。目前大模型的评测主要存在的难点:一是大模型能够完成各类任务,但是不同模型之间的差异很大;二是不同任务的评测指标不同,很难有统一衡量的标准;三是大模型的训练链越来越长,即使开源也难以复现,且容易导致数据泄露的情况。报告最后总结指出,大模型的评测应尽可能模拟真实用户使用场景,评测准确率应保证较高水准,评测数据量要足够,且整个过程应公开透明。只有围绕大模型长文本、跨语言、多任务、生成式的能力和特点,与场景和产品相结合,才能产生巨大价值。

天津大学熊德意教授的特邀报告题目为“中文大模型评测探索、实践与思考”。报告包括能力发展、安全治理、大模型评测实践以及评测整体思考等多个方面。在安全治理方面,熊德意教授着重强调了大模型的对齐研究是难点更是重点,论述了内部对齐、外部对齐和可解释性三者之间的关系,介绍了揭示模型漏洞的“红队测试(Red teaming)”和包含多种维度的基准评测等多种黑盒评测方法。报告还回顾了“巢邃杯”大模型发展大赛的情况,该比赛共测试了11款开源大模型和9款闭源大模型,从知识能力和价值对齐两方面进行了综合排名,引出了最终的思考与结论:大模型的评测应覆盖多个维度,测试基准应不断更新以防止数据污染,实时把控大模型的安全性,及时发布报告为后续的研发和发展提供指导,同时评测的组织方式可以采用“基础+shared tasks”模式或“通用维度组合+行业”的组合式,结合“自动+人工”的评测方法,最终实现完整合理的大模型评测。

任务1:第二届汉语框架语义解析评测

框架语义解析(Frame Semantic Parsing,FSP)是基于框架语义学的细粒度语义分析任务,其目标是从句中提取框架语义结构,实现对句子中事件或情境的深层理解。框架语义解析对阅读理解、文本摘要、关系抽取等下游任务具有重要意义。本次评测任务为汉语框架语义解析(Chinese FSP,CFSP),该任务包括三个子任务:框架识别(Frame Identification)、论元范围识别(Argument Identification)、论元角色识别(Role Identification)。相较于第一届,本次评测添加了面向短语级图示性构式、以构式为“目标词”进行框架语义解析的数据。该评测引起了工业界和学术界的广泛关注,共有1988支队伍报名参与,其中72支队伍提交了结果,6支队伍获奖,4篇论文被接收。

任务2:中文意合图语义解析评测

意合图(Chinese Parataxis Graph)是以事件为中心的语义表征图,为单根有向图,图中的节点对应承载事件、实体、属性的单元,边为有向边,表示单元间的语义关系。意合图在符合人类对语言认知的基础上,充分考虑落地应用的可操作性,使其尽可能层次化,以便后续语义分析路径的设计,实现通用性与扩展性兼具的语义表征方案。中文意合图语义解析评测任务仅要求生成句子级意合图框架,即输入单元为句子,输出为意合图框架结构,无需生成细化实体结构、情态结构、时空结构等内部语义分类,仅判断是否属于该结构成分即可。本次评测所提供的数据集来源于经人工标注的国际中文教育阅读文本与宾州树库语料,评测为开放式测试,允许使用外部资源。共有14支队伍报名,最终有7支队伍提交结果,4支队伍获奖,5篇论文被接收。

任务3:第四届中文空间语义理解评测

空间表达描述了物体之间的空间方位关系,是自然语言中的高频现象。要准确理解文本中空间表达语义,不仅需要语言知识,还需要具备空间认知能力,构建空间场景,并基于世界知识进行空间方位信息相关的推理。中文空间语义理解评测(Spatial Cognition Evaluation,简称 SpaCE)以测试机器中文空间语义理解水平为目标,自 2021 年开始连续举办了三届赛事。相较于前三届赛事,本届评测更加注重针对大语言模型的空间语义理解能力的测试,以选择题的形式考察空间信息异常识别、空间信息实体识别、空间信息角色识别、空间方位信息推理、空间形义关系判别五个层次的空间语义理解能力。最终共有12个团队提交了模型和结果,6支队伍获奖,5篇论文被接收。

任务4:第四届中文抽象语义表示解析评测

抽象语义表示(Abstract Meaning Representation,AMR)是近年来兴起的一种语义表示方法,能够将句子的语义结构抽象为一个单根有向无环图。中文抽象语义表示(Chinese Abstract Meaning Representation, CAMR)结合汉语的语言特点,在AMR基础架构上进行了改进,在保留AMR较强的整句语义表示能力的同时,主要新增了概念对齐和关系对齐的标注。本次评测的任务是对古代汉语句子进行解析,输出包含概念对齐信息和关系对齐信息的CAMR语义图,并按Align-smatch评测指标下的F1值进行成绩排名。相比往届,本次评测新增2677句古代汉语语料作为验证集和测试集,重点评价参赛模型的古汉语AMR解析性能;同时沿用往届的语料数据,包含20078句现代汉语,以观察解析系统在古代汉语上的迁移学习能力。由于难度较大,最终共有3个团队提交了解析系统和结果,2支队伍获奖,4篇论文被接收。

任务5:古文历史事件抽取评测

事件抽取是从自然语言文本中识别和提取相关事件信息。由于古文句法、语义复杂,使用范围小,针对古代汉语的信息抽取任务仍然面临着较大挑战。本评测旨在评估古文历史事件检测的算法性能,包括触发词识别(Trigger Identification)和事件类型判别(Event Type Classification)两个子任务。该评测构建了一个具有层级逻辑性的古文事件类型体系,一共包含9大类、67小类,然后基于古文事件类型体系和《二十四史》语料构建了中国古文历史事件检测数据集(A Cross-Historical Dataset with a Logical Event Schema for Classical Chinese Event Detection,CHED),共标注了8122个有效事件实例(包含触发词和事件类型)。共有28个团队报名参加,其中学术机构团队17个,商业机构团队2个,独立团队或个人9个,最终共有15个团队提交了模型和结果,3支队伍获奖,4篇论文被接收。

任务6:中小学作文修辞识别与理解评测

在中小学生的学习过程中,修辞手法不仅是阅读理解和写作技巧的核心组成部分,同时也是塑造优秀文学作品的不可或缺的元素。识别并理解学生作文中的修辞使用,可以帮助学生提高作文表达能力,指导学生更高质量的叙述和描写。本次评测围绕“中小学作文修辞理解”任务,将修辞手法分为比喻、比拟、夸张和排比,进一步对这4种修辞手法进行细粒度分类,并给出每种修辞描写的对象和内容,包括:中小学作文修辞形式类型识别、中小学作文修辞内容类型识别、中小学作文修辞成分抽取。评测包含3个赛道,共有32支队伍注册参加评测,最终9个团队提交了评估结果并获得了有效分数,其中7个团队的总分超过了基线,5支队伍获奖,6篇论文被接收。

任务7:中小学作文流畅性评价

中小学生作文流畅性评价(Chinese Essay Fluency Evaluation, CEFE)任务旨在对影响作文流畅性的错误进行识别和纠正。目前的工作通常将作文流畅性评价作为单独的自然语言处理任务,缺乏多层次、多角度的系统性整合。本次评测从词法、句法、语义等角度系统地定义了影响中小学作文流畅性的细粒度错误类型,并提供修正建议。与去年相比,为进一步全面地对作文的流畅程度进行评估,本次评测新增作文流畅性评级任务,并在训练集中新增1200条句子。评测设计了中小学作文病句类型识别、中小学作文病句重写、中小学作文流畅性评级3个赛道,共有29个队伍报名参与评测,10个队伍提交了结果,5支队伍获奖,6篇论文被接收。

任务8:儿童故事常识推理与寓意理解

故事包含大量的社会、物理等常识,同时蕴含深刻的道理,是知识传播、文化传承、 价值塑造的重要载体。故事理解是NLP中的一项重要任务。但目前对模型故事理解能力的评价与分析非常有限。儿童故事常识推理与寓意理解评测(Evaluation on Commonsense Reasoning and Moral Understanding in Children’s Stories,CRMU)基于人类故事理解的认知过程,构建了一个寓言故事理解数据集CRMUS,设计了常识推理、寓意理解两个任务来评价中文预训练语言模型和大型语言模型的常识推理和故事理解能力。其中,常识推理涉及到的常识类型包含时间常识、空间常识、生物常识、物理常识以及社会常识。评测共有33个团队报名,最终15个团队提交了结果,8支队伍获奖,5篇论文被接收。

任务9:中文图文多模态理解评测任务

中文图文多模态理解评测(Chinese Vision-Language Understanding Evaluation,CVLUE)任务旨在从图文检索(Image-Text Retrieval)、视觉问答(Visual Question Answering)、视觉定位(Visual Grounding)和视觉对话(Visual Dialog)等四个任务多角度评价中文图文多模态预训练模型的图文多模态建模和理解能力。该任务包含图片检索(Image Retrieval)、文本检索(Text Retrieval)、视觉问答(Visual Question Answering)、视觉定位(Visual Grounding)、视觉对话(Visual Dialog)5个子任务。本次评测任务共有11支队伍报名参赛,由于任务较为困难,最终只有3支队伍提交了模型和结果,1支队伍获奖,3篇论文被接收。

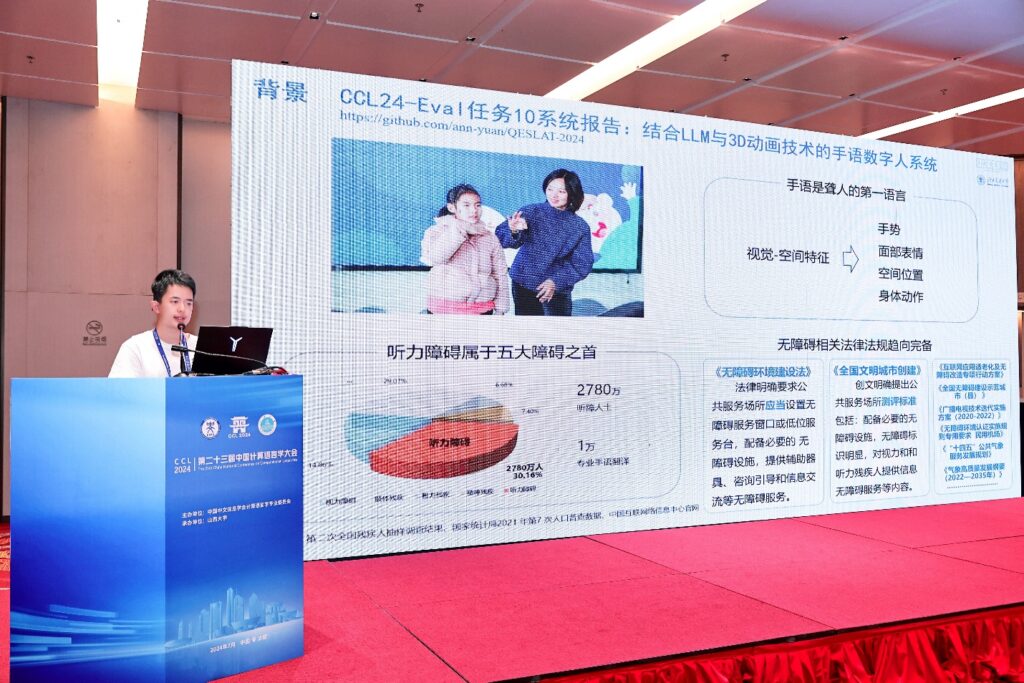

任务10:手语数字人翻译质量评测

手语数字人(Sign Language Avatars)通过模拟手语动作,为聋人提供实时的翻译服务,有助于打破语言障碍,提升聋人群体的社会参与度。本次评测由中国聋人协会手语研究与推广委员会业务指导,旨在评测手语数字人将汉语翻译成中国手语方面的自然性和准确性,确保手语数字人能够符合手语语法规则,并且能够被聋人群体所理解和接受。评测将以手语语法的准确性、表达的自然性和可读性以及是否满足聋人理解为主要标准,综合考虑手势清晰度、流畅性、与汉语原文的语义一致性等要素。具体包括手语语法准确性、自然性、可读性、文化适应性四个评测标准。共有14个团队注册并申请了语料库,其中9个来自学术界,5个来自工业界,最终有10个团队提交了结果,3支队伍获奖,3篇论文被接收。

总结

CCL24-Eval总计参赛队伍2197支,提交结果156份,奖金8.4万元,获奖队伍43支,被接收论文45篇(中文22篇,英文23篇)。本届技术评测录用的所有论文将继续以中英文形式发布在ACL Anthology的CCL track中,以提升评测的国内外影响力,推动中文信息处理技术的发展。

来自山西大学的谭红叶教授对CCL24-Eval做了总结报告:十个评测任务种类多样,组织单位以高校为主,展现出了较强的学术性。首先,评测的举办能够有效地反映模型能力,加速技术迭代,推进技术的研发。其次,一定程度上反映用户意图,帮助技术选型,指导资源高效配置,具有较高的社会服务价值。最后,评测促进了各个大模型之间的竞争与合作,推动学科交流,起到了合作交流的带头作用。

总体而言,本届评测任务类别繁多,展示了自然语言处理研究的多样与复杂。参赛队伍在各个任务中表现出色,不仅服务了社会需求,也推动了学术研究的进步,为自然语言处理的发展注入了新的动力、提供了新的方向。在大模型时代背景之下,中文信息处理领域将会有更多的机遇与挑战,相信未来的CCL技术评测研讨会定会出现更多的创新与突破。

CCL 2025的评测即将开启任务征集与报名工作,请继续关注会议信息。